- Liittynyt

- 14.10.2016

- Viestejä

- 22 611

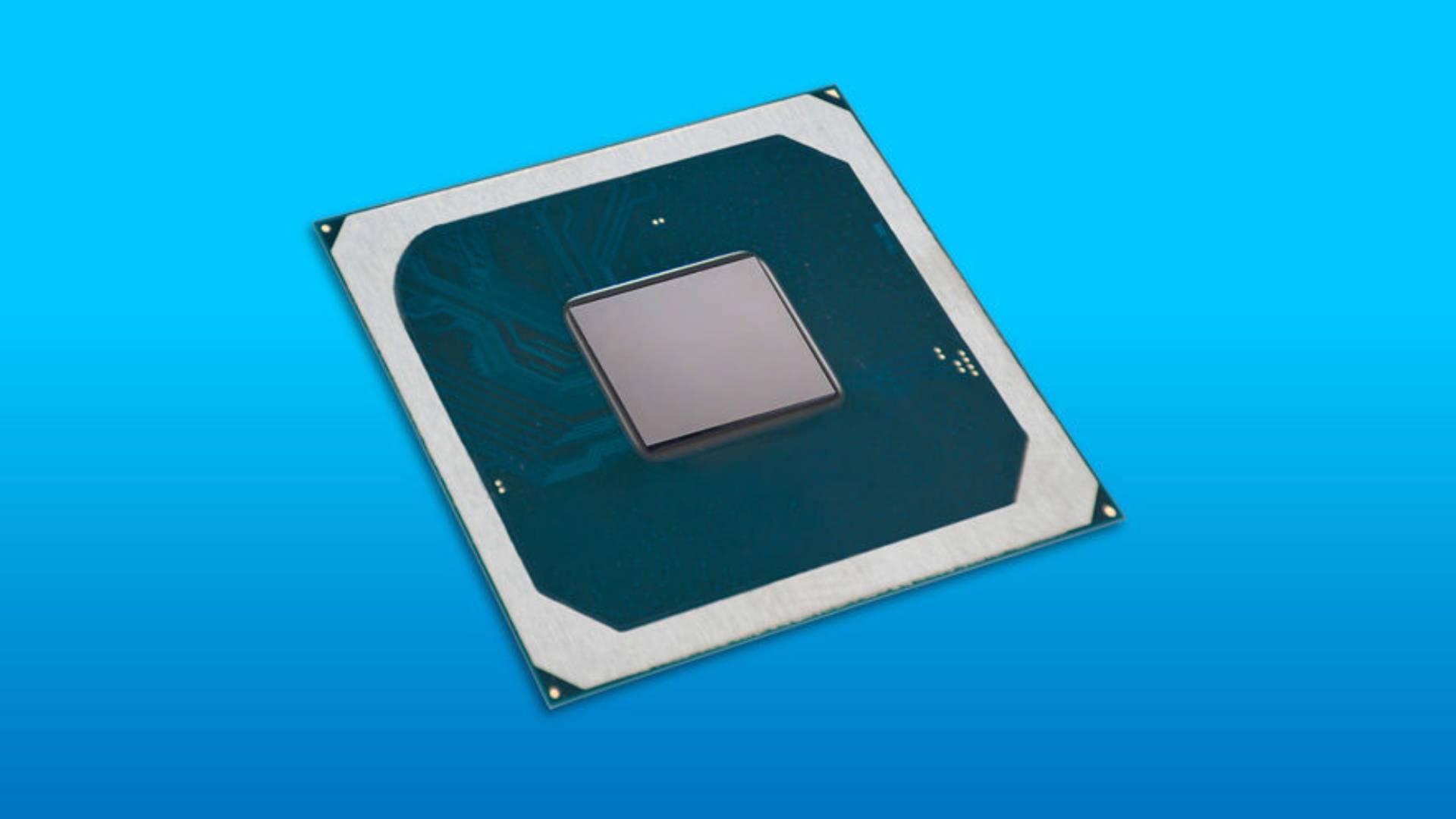

Neljään Xe-LP-grafiikkapiiriin perustuva Intel Server GPU "H3C XG310" on suunniteltu median streamauspalveluihin sekä Android-pilvipelien pyörittämiseen matalin viivein.

newsroom.intel.com

newsroom.intel.com

Intel Executing toward XPU Vision with oneAPI and Intel Server GPU

Intel announces key milestones in its multiyear journey to deliver a mix of architectures with a unified software experience.