- Liittynyt

- 14.10.2016

- Viestejä

- 21 870

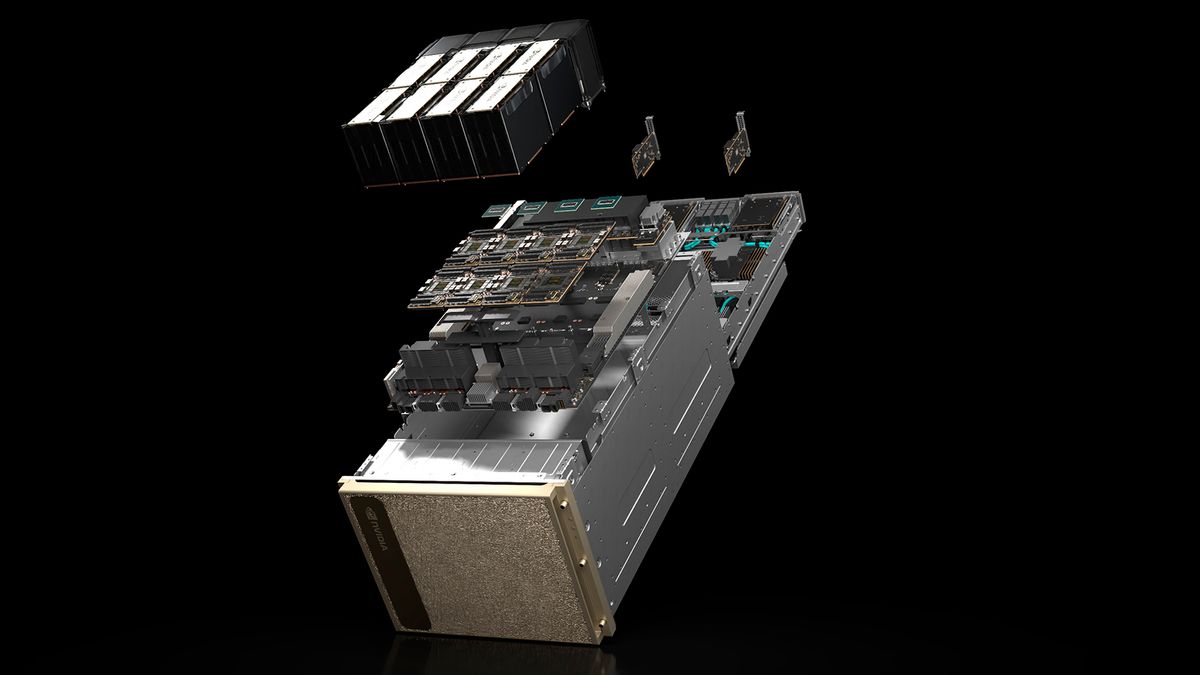

Dellin operatiivinen johtaja Jeff Clarke on maininnut kuin ohimennen NVIDIAn tulevan B200:n tulevan kuluttamaan jopa 1000 wattia per GPU, kun hän kertoi yhtiön todenneen ettei nestejäähdytys ole sille pakollista.

B200 on tämän hetkisten tietojen mukaan NVIDIAn omia prosessoreita hyödyntäviin palvelimiin tarkoitettu versio B100:sta, joka ilmeisesti tulee kuluttamaan jonkin verran vähemmän tehoa. B100 tulee saataville sekä SXM6- että PCIe-versioina.

B200 on tämän hetkisten tietojen mukaan NVIDIAn omia prosessoreita hyödyntäviin palvelimiin tarkoitettu versio B100:sta, joka ilmeisesti tulee kuluttamaan jonkin verran vähemmän tehoa. B100 tulee saataville sekä SXM6- että PCIe-versioina.

Lähde: Dell Exec Confirms NVIDIA’s Monster Blackwell AI Accelerator Is ComingWe're excited about what happens at the B100 and the B200, and we think that's where there's actually another opportunity to distinguish engineering confidence. Our characterization in the thermal side, you really don't need direct liquid cooling to get to the energy density of 1,000 watts per GPU. That happens next year with the B200.