- Liittynyt

- 14.10.2016

- Viestejä

- 22 495

Kaotik kirjoitti uutisen/artikkelin:

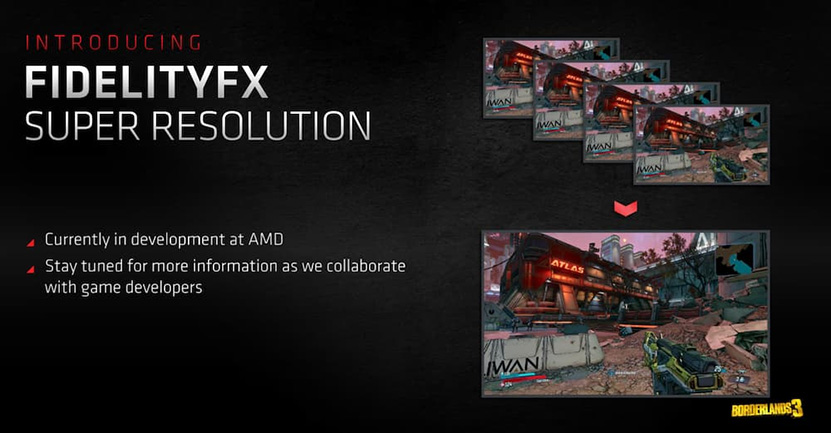

AMD kertoi jo viime vuonna valmistelevansa uutta FidelityFX Super Resolution -skaalausta kilpailemaan NVIDIAn DLSS:n kanssa. Yhtiö ei ole kuitenkaan hiiskunut asiasta sen jälkeen käytännössä yhtään mitään.

Nyt yhtiön Radeon-siiven johtaja Scott Herkelman on kertonut PCWorldin haastattelussa uutta tietoa ominaisuudesta. Herkelmanin mukaan virallisesti SFR-lyhennettä käyttävä ominaisuus on todennäköisesti yhtiön suurin ohjelmistopuolen projekti tällä hetkellä ja että yhtiö uskoo saavansa julkaistua sen tämän vuoden aikana. Valitettavasti sen tarkempaa aikataulua haastattelussa ei herunut.

[embed]

Haastattelun perusteella AMD ei ole vielä lyönyt lukkoon FidelityFX Super Resolutionin skaalausmetodia, vaan se punnitsee edelleen eri metodien hyötyjä ja haittoja keskenään. Herkelmanin mukaan ei ole esimerkiksi itsestään selvää, että se tulisi käyttämään koneoppimista, vaan tärkeintä on löytää toteutus, jota pelinkehittäjät ja pelaajat haluavat käyttää. Hänen viestinnästään on tulkittavissa myös mahdollisuus, että yhtiö mahdollisesti esittelisi useampia vaihtoehtoisia tekniikoita ennakkoon, joista yksi valittaisiin lopulliseksi FSR:ksi. FidelityFX Super Resolutionin on tarkoitus tulla myös konsoleille, mutta tällä hetkellä PC-julkaisu on prioriteettilistalla korkeammalla.

FSR-osuus alkaa PCWorldin haastattelussa ajassa 32 minuuttia ja 42 sekuntia.

Linkki alkuperäiseen juttuun

[/embed]