huomioita netistä ja kommentteja...

hmm,ensiksi rdna3 syö aika varmasti lähelle 500w tehoja,ellei, voi unohtaa kamppailut rtx 4000 vastaan,tehoja kun ei tule ilmaiseksi,

ellei amd ole keksinyt välttää fysiikan lakeja tai sanotaan todella nopean auton polttomoottorilla joka vie vähän bensaa... lol

ja sitten, tulevat näykkärit?! kummaltakin tulossa hirmuisia petoja..oikeastaan mihin niitä,varsinkin top malleja tarvitaan.....nooh, joku pelaa 34-55" näytöllä 4K:lla tai jopa 8K:lla,

pienen pieni osa pelaajista kuitenkin,0,5%...

koskahan tulee näykkäreihin eu direktiivi tai jotain, esim max virrankulutus.. vaikka 350-500w? ois ihan ok nykyaikana.

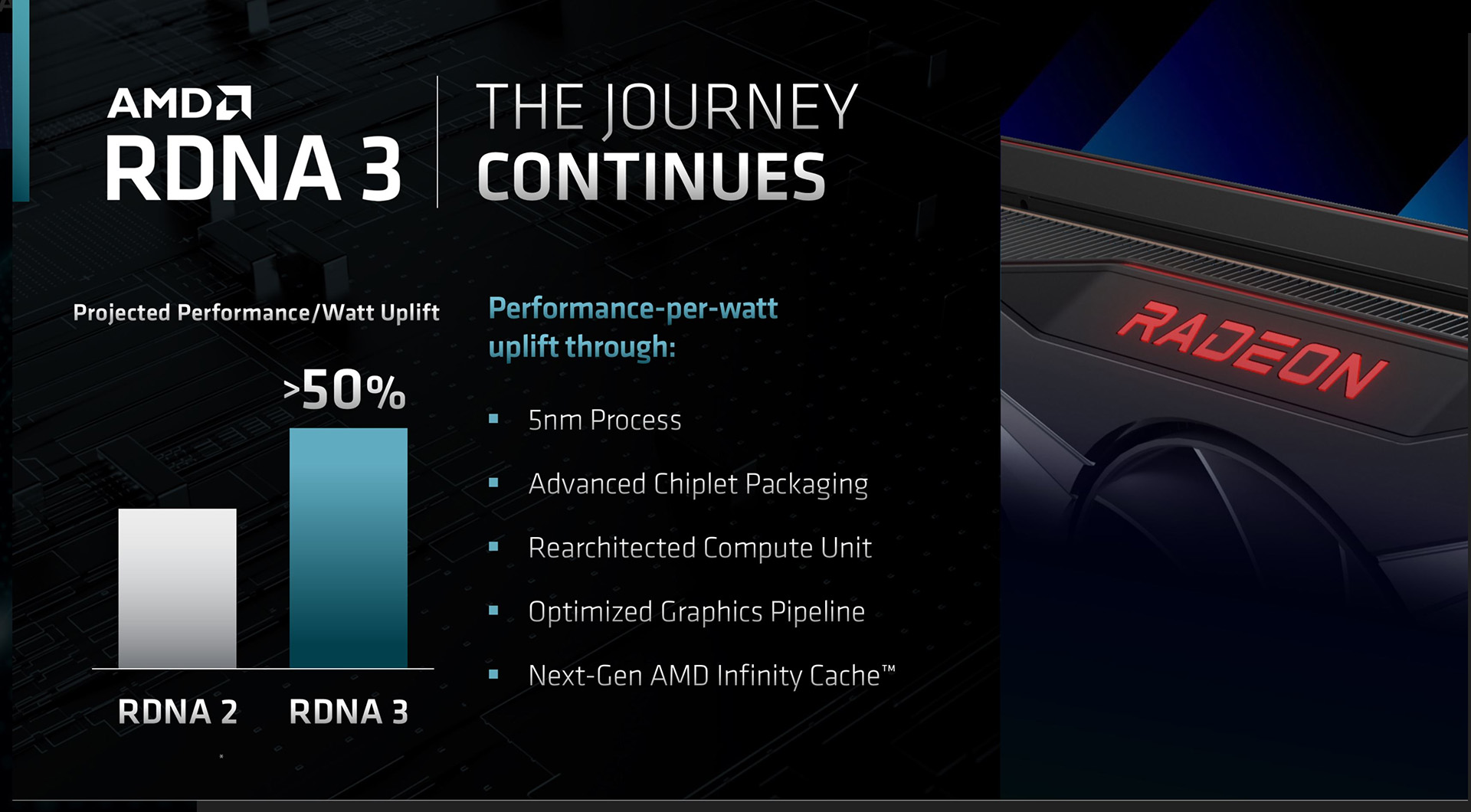

toiseksi, täytyy muistaa että nvidia näykkärit on nyt pitkästä aikaa,samalla viivalla rdna3:n kanssa, molemmat 5nm tehty(nvidian tosin optimoitu 5nm,sanotaan 4N malliksi), joten katsotaan se virran kulutus sitten....

kuitenkin..huhuista päätellen näyttää että nvidia on ottanut kaiken tehon irti korteistaan välittämättä virranotosta,mutta noilla tehopakkausksilla 450W on normaalia.

sillä jos muistetaan.. ,amd teki vega ja fury x:n 7 vuotta sitten, eli kivikausi välissä ja kortit vei virtaa ihan älyttömästi suorituskykyyn verrattuna,saman tai melkein kuin nyt tulevat uudet kortit...

eipä kauheesti ollut silloin krtitiikkiä. arkistot siellä on.....?

no....googlella voi kattoa watteja,esim techpowerup sivusto

esim. furmark gtx 1080 ti 267w vs fury x 432W! ja gtx 2080 ti 285w vs amd vega 64 309w!

jopa io-tecin omassa testissä söi yli 100W enmmän kuin 1080 oc,, loppuraportti...huh! no, ulkomaiset sivut sentään..jotain

siellä se on, haulla vaan.. suorituskyky oli eri luokkaa myöskin.

ja tosiaan,silti testeissä amd korttien virrankulutukseen ja lämpöihin suhtaudutiin aika löysästi,vaikka nvidia piti watit ja metelit kohtuu lukemissa,kytättiin vain fps:jä..

harvoin luin testeistä kritiikkiä amd vega ja fury x malleille.. noh,mitä nvidia siitä teki päätöksiään....

nyt kun kaksi (2)kertaa rtx 3090 tehoinen kortti (huhu edelleen)ja oisko 4 kertaa vega suorituskyky antava kortti, rtx 4090 tulee ja watteja menee 150W enenmmän....blaa blaa.

come on..

nyt, rx 6950 vei saman jo kuin 3090 (sitten kun pärjää suorituskyvyssä)ja peakissa paljon enemmän. (rx 6950 formula)

jos rdna3 aikoo edes lähelle rtx 4090 tehoja sanon että 450-550w on aika hyvä arvio. jos alle 400W...

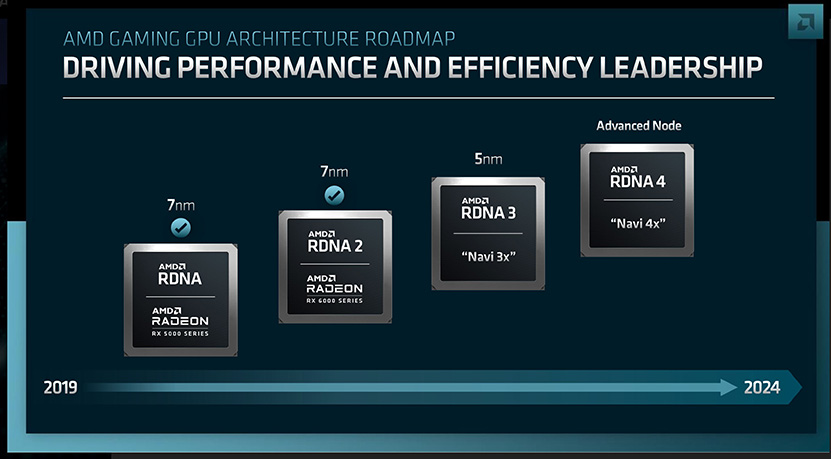

nvidia adalovelace titan ,eli oisko rtx 4090 ti,on sitten kortti jolla nvidia pitää vain huolta että on nopein kortti maan päällä kunnes rtx 5000:t (tai rdna4:t)saapuu 2024/2025

tehonkulutus? who cares!

io-tech modet ja pomot,koittakaa nyt edes... yrittäkää edes olla puna/vihreitä(sini) värisiä... siis objektiivisia...koko ajan saa lukea amd siellä amd täällä..hmm, paha siinä on vertailla...

intel näykkärit?...en oikein usko noihin, lohkaisee kyllä budget luokasta oman osansa,jos ajurit on kunnolliset.

lopuksi#2, jos 5nm zen4 ei pese 10nm intel raptoria, ei hyvä amd cpu sektorille.

mutta silti,todella,todella hankalaa on amd:n cpu sektorille sitten vuodet 2023-2025, kun meteor,arrow,lunar ja nova laket saapuu, vimppa 2025

eli järjestyksessä 7nm,optimoitu 7nm(5nm),3nm,1.8nm

njoo, intelkin nöyrtyi ja laitto rahaa tiskiin ja ostaa TSMC tekniikkaa..sehän on itse tehnyt prossunsa tähän saakaa, amd aina kumartanut TSMC:lle syvään ja ilman heitä, ei olisi ryzeneitä.

eikä varsinkaan 7nm ryzeneitä,niillä amd on rummutellut..tähän saakka.,ja hyviähän ne on kun verrattin intelin 14nm prossuun..bah! tarvittiin vain 10nm alder lake ja kupla hajosi..

mites olisi 7nm meteor lake vs 7nm ryzen...ei piru vie,lisa su tarvitsee tasaväkiseen kamppailuun väh. 5nm prossun..heh

noh, eiköhän siinä ollut vähän viihdykettä ja erhh...jauhantaa,lol

kaikille oikein hyvää kesää!